Wer kennt nicht die Bilder und Szenen, wenn auf Technologiemessen ein begeisterter Mensch dem „süßen“ kleinen Roboter „Pepper“ über den Kopf streicht, ihm wie einem Kind in die „Augen“ schaut, als ob dieses vermeintliche Geschöpf dann dankend zurücklächelt. Der Mensch sucht Interaktion und projiziert Interaktionsfähigkeit auf den mobilen Blechhaufen.

Einem solchen Menschen gab der nachdenkliche Technikethiker Karsten Weber einen ernüchternden Rat mit auf den Weg: „Hinter diesen Augen sitzt kein Ich.“ Mit dieser Äußerung wollte der Wissenschaftler aus Regensburg jenen widersprechen, die in der momentanen Roboterentwicklung schon Maschinen „mit Bewusstsein“ zu erkennen glaubten. Davon sei man mehr als weit entfernt, wenn dieses Ziel überhaupt je erreicht werden könnte.

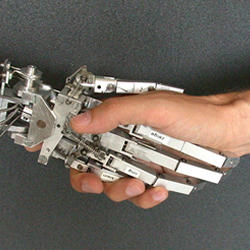

Die Projektion menschlicher Eigenschaften auf die Maschinen sei unangebracht und falsch. Weder menschenähnliche Roboter noch selbst fahrende Autos besäßen jene „Autonomie“, die es ihnen erlauben würde, selbst ethische bzw. normative Regeln zu setzen. Dies sei und bleibe Aufgabe des Menschen.

Auf einer Tagung zum Thema „Künstliche Intelligenz“ der Integrata-Stiftung und des Tübinger Weltethos-Institutes kritisierte Weber den unverantwortlichen Umgang mit schwerwiegenden moralischen und ethischen Fragen bei der Entwicklung der KI. Die „Anthropomorphisierung von Maschinen“ (Übertragung menschlicher Eigenschaften auf Maschinen) sei ein gravierender Fehlschluss.

Der Technikethiker verwies wissenschaftlich methodisch präzise auf die Erfahrungen mit Technikentwicklungen der letzten Jahrzehnte. Technik sei nie neutral, sie sei immer wertebasiert, wertegebunden und wertebeladen. Dies bedeute, dass bei der Konzipierung technischer Innovationen immer bewusst oder unbewusst normative Überzeugungen, Werte, Vorurteile, Interessen in die Technikentwicklung einfließen. Dies schließe ein, dass immer wieder ein Hinterfragen vorhandener Technik stattfinden müsse, da sich parallel zur Technikentwicklung auch gesellschaftliche Werte und Lebensstile (zum Beispiel Geschlechterrollen) ständig veränderten.

Diese Wertegebundenheit technischer Konzeptionen müsse – so die Diskussion – gerade bei einem besonders empfindlichen Teil der KI, nämlich der Nutzung von „selbstlernenden Software-Systemen“, deutlichere Berücksichtigung finden. Denn auch hier gilt: Hinter diesen Algorithmen sitzt kein Ich.