Seit mehreren Jahren wird im gewerkschaftsnahen Forum Soziale Technikgestaltung (FST) über die Möglichkeiten diskutiert, wie neuere Formen von selbstentscheidender und sich-selbst-verändernder Software an rechtliche Vorgaben und soziale Standards angepasst werden können. Für die soziale Gestaltung von Algorithmen und algorithmischen Entscheidungssystemen hat das FST dreißig grundsätzliche (generische) Kriterien entwickelt und zur Diskussion gestellt. Auf diese Weise sollen Software-Systeme, die durch ständige neue Datenaufnahmen veränderte Entscheidungen treffen können, demokratisch und human ausgerichtet werden.

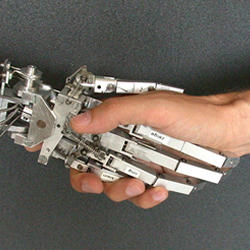

Diese Gestaltungsprozesse müssen einerseits durch neue Wege der betrieblichen Mitbestimmung durchgesetzt werden. Andererseits benötigt unsere politische Zivilgesellschaft verbindliche rechtliche Spielregeln, wie verankert und institutionell abgesichert werden kann, dass technische Systeme nicht die Oberhand über den Menschen, über die Bürgerin, über den Bürger gewinnen. Eine demokratische Gesellschaft muss gewährleisten, dass technische Innovationen als Assistenzsysteme wirken, aber nicht als Delegationssysteme anstelle des Menschen entscheiden. Der Mensch muss das Interventionsrecht besitzen. Entscheidungen über Menschen sind von Menschen zu treffen nicht von vermeintlich „selbstlernenden“ Software-Systemen.

Der Einsatz solcher algorithmischer Entscheidungssysteme in den Gesundheitswesen in den USA hat sehr deutlich gezeigt, dass nicht-gestaltete und gesellschaftlich nicht-kontrollierte Algorithmen vorhandene Vorurteile, Ausgrenzungen und Rassismen verstärken. Mangelhafte Aushandlungsprozesse zwischen Entwickelnden und Nutzenden (Spezifizierungen) befördern verdeckte oder offene Diskriminierung anstatt sie zu beseitigen. Auch für die gesellschaftliche Implementierung der Algorithmen und der algorithmischen Entscheidungssysteme gilt: Black lives matter.